這個活動是修改自THE AMERICAN BIOLOGY TEACHER(VOLUME. 79, NO. 2, FEBRUARY 2017)的 Modeling Evolution in the Classroom: An Interactive LEGO Simulation連結

http://abt.ucpress.edu/content/79/2/128

原本這是用樂高積木進行的模擬活動,不過我在幾次試作之後進行了修改,把活動的基本設定、材料方法等都變了不少。現在這個版本,也是我認為比較好在教室實施的活動版本。

我將整個進行流程錄製成九分多鐘的影片,我想看影片操作應該會比看文章容易懂。

VIDEO

材料:

學生組的材料。30個人的班級,需要準備七到八組,每組3-4人。

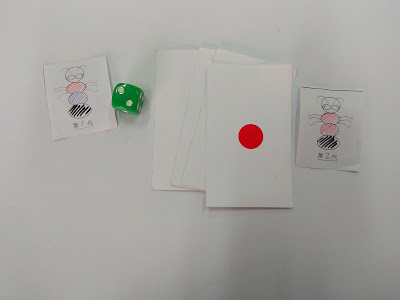

數張A4紙、口紅膠、空白小蟲蟲卡數十張、黃筆(學生自備紅藍黑筆)、骰子、上面貼著紅藍黑黃貼紙的卡片各一張(以下簡稱貼紙色卡)。

老師準備的材料:

一張卡片紙上貼三種顏色的貼紙,紅藍黑黃任選三色,三色不重複。這樣的卡片至少準備30張以上。每張卡片的一邊都用用打洞機打一個洞,代表卡片的上方。

活動故事設定:

每個人都是一隻小蟲蟲,身上有著三種不同的顏色。本來大家都生活在一個大島上,後來因為附近有火山爆發,出現了七個小島。大島上的小蟲蟲因為海漂、迷路等原因飄散到七個小島了,當然會吃小蟲蟲的大鳥鳥也飛到這些小島上了。

每個小島上面的環境顏色都不太相同,這些小蟲蟲身上的顏色就成了牠們的護身符了。

體色和島嶼顏色一樣,就能獲得保護不會被大鳥鳥吃,因此得以繁殖下一代。

這些小蟲蟲都是無性生殖的個體,所以也沒有求偶交配這件事,只要自己一隻就能繁殖。

如果身上有一個體節顏色和島嶼一樣,就可以生下一隻後代。若是兩個體節和島嶼顏色一樣,就能生兩個後代,若是三個體節顏色都和島嶼顏色一樣,則可以生三個後代。

體色和島嶼顏色一點都不像的,就會被大鳥鳥吃掉。

生完小孩的小蟲蟲會蟲老珠黃,不能再生小孩了。

繁殖的規則是用骰子決定,骰到1,則第一個體節顏色會突變,骰到2,就是第二個體節,骰到3就是第三個體節。如果骰到456就是不突變,下一代的體色和親代一樣。每生一個後代,都要骰一次骰子。

左圖的小蟲蟲要生殖,骰子點數骰到2,抽色卡抽到紅色,所以第二體節變紅色

活動故事分成三階段

第一階段是同一個小島的顏色有兩種,比方說同一塊島嶼東邊是藍色,西邊是紅色環境,在上面生存的小蟲蟲可以任意移動到適合自己生存的環境,而且下一代的小蟲蟲不一定要跟親代住在一起,牠們也可以任意移動到東邊或西邊。

第二階段是又發生地震了,本來一塊島嶼有著藍色和紅色的環境,現在分裂了。上面生存的小蟲蟲再也不能任意移動了。牠們只能在自己這塊島嶼上努力生存著。

第三階段環境大變遷,島嶼的兩色完全改變顏色了。

活動進行說明

每組用抽貼紙色卡來決定自己的島嶼是哪兩種顏色,兩種顏色不重複,然後在兩張A4紙的左上方把島嶼顏色用色筆畫出來(或用貼紙貼出顏色)。再用口紅膠把兩張A4紙拼貼成一張,代表小島。

每個學生到講桌來抽貼有三色貼紙的卡片,學生抽到的卡片,就代表了學生那隻小蟲蟲的體色,學生回到自己座位,用色筆在空白小蟲蟲卡片上塗上卡片上貼紙的顏色,最好也在小蟲蟲上面寫上自己的名字。

老師準備的貼紙色卡,給學生抽的時候要翻面藏住貼紙

學生抽到什麼顏色,就依照顏色順序,在小蟲蟲身上畫下該色

四人一組,因此這組就會畫出四隻小蟲蟲

階段一:新族群的建立

選定自己這隻小蟲蟲應該住在哪種顏色的島嶼上,才能順利存活下來,選好以後,就用口紅膠把小蟲蟲貼在那塊島嶼上定居,然後就不會再移動了。

進行生殖時,依照前述規則丟骰子決定下一代的體色,然後拿新的空白小蟲蟲把體色畫上去,再決定牠應該住在哪邊比較適合,接下來就是用口紅膠幫牠定居。

如果出現下一代無法住在東或西,就讓牠住在親代那一邊,然後在這蟲上面畫個叉叉寫個死,代表不適應環境就死掉了,用上述做法連續生三代或四代。

階段二:火山爆發,島嶼分裂

再拿兩張A4紙貼在前述島嶼的下方,只是兩張紙需要約略分開,象徵分開的兩個島嶼。依著同樣的規則在火山爆發分裂的島嶼上再生四代。

第三階段:環境鉅變,島色大改變

島嶼顏色又改變,用抽色卡的方式決定島嶼顏色變成什麼顏色,然後再繼續生三或四代

活動提問

Q.在這活動中,造成個體差異的原因是什麼?

A.小蟲蟲都是無性生殖,造成個體差異的原因主要來自突變。

Q.小蟲蟲發生突變是好的還是壞的?

A.不一定,有些突變會造成整個島的小蟲蟲滅團,但是有些突變卻會造成暴增,而有些突變是沒差。

A.蟲蟲數量要夠多,個體差異要夠大

A.這些小蟲蟲都是同一種,彼此之間有個體差異,所以是遺傳多樣性。

Q.從這個活動中,生態系多樣性怎麼支持遺傳多樣性?

A.有不同顏色的島嶼,才能讓不同體色的小蟲蟲有機會生存,島嶼顏色越多樣,小蟲蟲就越不容易滅掉。

Q.哪種島嶼比較容易滅團?分離的島嶼?連在一起的島嶼?

A.分離的島嶼比較會滅團,而一開始連在一起的島嶼,雖然每個島顏色都不一樣,但是小蟲蟲可以隨意移動。

Q.第二階段的天擇力量和第一階段相比,哪個天擇力量比較強

A.第二階段是比較強的,很容易篩選出特定顏色的小蟲蟲

Q.在最開始的時候,島嶼上的小蟲蟲族群是怎麼出現的?

A.是隨機抽卡到那個島的

探究取向的提問

在每一階段一開始,先提問

Q.你推測每代的顏色比例變化會發生什麼事情?寫下你的假設之後,解釋原因

在第一階段中,學生一開始可能會認為在藍島的,藍色會變多,而在紅島的紅色會變多,部過由於兩個島嶼是相連的,所以不容易看到這種趨勢。而到了第二階段就比較容易看到這樣的趨勢了。

每階段的模擬結束後,提問

Q. 實驗結果符合你的假設嗎?如果不符合,那有什麼可能原因?

活動結束前的提問

Q. 如果我們將遊戲持續到第十代或是更多代,你推測會發生什麼事情?請解釋為什麼你會這麼想?

Q. 如果要讓天擇的力量更強,要怎麼設計規則?如果你這樣做了,演化的速率會怎麼改變?

Q. 如果要讓突變的機率提高,要怎麼設計規則?如果你增加了突變速率,那麼演化速率會怎麼改變?

Q.思考一下,這個活動還可以改變什麼設定?如果這個設定值改變了,那麼結果會怎樣?寫下你的假設?

其實這個活動最初設計是用在大學上,所以是可以再用此活動在介紹專有名詞,像是創始者效應、棲地切割、等位基因頻率。

等位基因頻率的計算方式,先假設小蟲蟲的體色分別就是三個等位基因決定,所以就用體色的比例來當作等位基因的頻率。比方說,觀察下圖的第一代共四隻,分別是黑紅藍、藍紅黑、紅黃黑、紅黃黑。所以黑色的比例就是4/12,紅色是4/12,藍色是2/12,黃色是2/12。

計算每一代的等位基因頻率變化,就可以得到這樣的圖。左邊的是島嶼結合時,四種顏色的比例,右邊兩張圖分別是分離之後的兩個島嶼。右上的圖,這個一個島完全沒有紅色,因為一開始就沒有紅色的小蟲蟲。

後記

其實這個活動我修改了好幾次,從一開始想要跟著用樂高積木來做,結果發現太貴。後來就想到用串珠,可是串珠太容易滾動,上個課下來地上好多珠珠,而且珠珠也沒辦法擺著不拆,因為生到最後珠珠一定不夠用。但最好是可以把歷代的個體都留下來,所以珠珠就也沒那麼好用了。島嶼的底紙一開始我是去買有色的雲彩紙來墊底,不過後來我希望簡單準備就好,所以就改成A4紙了。

用四色串珠和拗直的迴紋針來進行活動

用紙卡作為個體,島嶼則是特定的顏色